centos.repo

[baseos]

name=CentOS Stream $releasever - BaseOS

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/BaseOS/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-baseos-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=1

[baseos-debuginfo]

name=CentOS Stream $releasever - BaseOS - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/BaseOS/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-baseos-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[baseos-source]

name=CentOS Stream $releasever - BaseOS - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/BaseOS/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-baseos-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[appstream]

name=CentOS Stream $releasever - AppStream

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/AppStream/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-appstream-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=1

[appstream-debuginfo]

name=CentOS Stream $releasever - AppStream - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/AppStream/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-appstream-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[appstream-source]

name=CentOS Stream $releasever - AppStream - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/AppStream/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-appstream-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[crb]

name=CentOS Stream $releasever - CRB

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/CRB/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-crb-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=1

[crb-debuginfo]

name=CentOS Stream $releasever - CRB - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/CRB/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-crb-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[crb-source]

name=CentOS Stream $releasever - CRB - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/CRB/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-crb-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

centos-addons.repo

[highavailability]

name=CentOS Stream $releasever - HighAvailability

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/HighAvailability/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-highavailability-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=0

[highavailability-debuginfo]

name=CentOS Stream $releasever - HighAvailability - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/HighAvailability/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-highavailability-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[highavailability-source]

name=CentOS Stream $releasever - HighAvailability - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/HighAvailability/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-highavailability-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[nfv]

name=CentOS Stream $releasever - NFV

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/NFV/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-nfv-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=0

[nfv-debuginfo]

name=CentOS Stream $releasever - NFV - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/NFV/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-nfv-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[nfv-source]

name=CentOS Stream $releasever - NFV - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/NFV/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-nfv-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[rt]

name=CentOS Stream $releasever - RT

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/RT/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-rt-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=0

[rt-debuginfo]

name=CentOS Stream $releasever - RT - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/RT/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-rt-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[rt-source]

name=CentOS Stream $releasever - RT - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/RT/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-rt-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[resilientstorage]

name=CentOS Stream $releasever - ResilientStorage

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/ResilientStorage/$basearch/os

# metalink=https://mirrors.centos.org/metalink?repo=centos-resilientstorage-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=0

[resilientstorage-debuginfo]

name=CentOS Stream $releasever - ResilientStorage - Debug

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/ResilientStorage/$basearch/debug/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-resilientstorage-debug-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[resilientstorage-source]

name=CentOS Stream $releasever - ResilientStorage - Source

baseurl=https://mirrors.hetao.me/centos-stream/$releasever-stream/ResilientStorage/source/tree/

# metalink=https://mirrors.centos.org/metalink?repo=centos-resilientstorage-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-centosofficial-SHA256

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

[extras-common]

name=CentOS Stream $releasever - Extras packages

baseurl=https://mirrors.hetao.me/centos-stream/SIGs/$releasever-stream/extras/$basearch/extras-common

# metalink=https://mirrors.centos.org/metalink?repo=centos-extras-sig-extras-common-$stream&arch=$basearch&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-SIG-Extras-SHA512

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

countme=1

enabled=1

[extras-common-source]

name=CentOS Stream $releasever - Extras packages - Source

baseurl=https://mirrors.hetao.me/centos-stream/SIGs/$releasever-stream/extras/source/extras-common

# metalink=https://mirrors.centos.org/metalink?repo=centos-extras-sig-extras-common-source-$stream&arch=source&protocol=https,http

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-SIG-Extras-SHA512

gpgcheck=1

repo_gpgcheck=0

metadata_expire=6h

enabled=0

docker-ce.repo

[docker-ce-stable]

name=Docker CE Stable - $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/$basearch/stable

enabled=1

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-stable-debuginfo]

name=Docker CE Stable - Debuginfo $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/debug-$basearch/stable

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-stable-source]

name=Docker CE Stable - Sources

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/source/stable

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-test]

name=Docker CE Test - $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/$basearch/test

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-test-debuginfo]

name=Docker CE Test - Debuginfo $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/debug-$basearch/test

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-test-source]

name=Docker CE Test - Sources

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/source/test

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-nightly]

name=Docker CE Nightly - $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/$basearch/nightly

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-nightly-debuginfo]

name=Docker CE Nightly - Debuginfo $basearch

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/debug-$basearch/nightly

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

[docker-ce-nightly-source]

name=Docker CE Nightly - Sources

baseurl=https://mirrors.hetao.me/docker-ce/linux/centos/$releasever/source/nightly

enabled=0

gpgcheck=1

gpgkey=https://mirrors.hetao.me/docker-ce/linux/centos/gpg

Views: 51

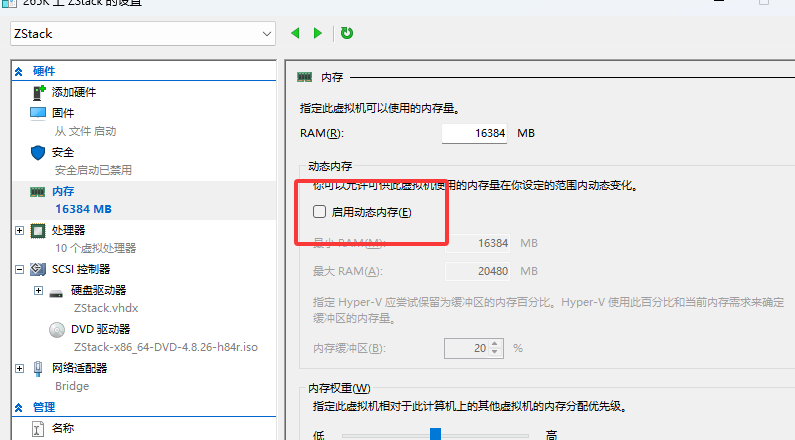

关闭动态内存

关闭动态内存

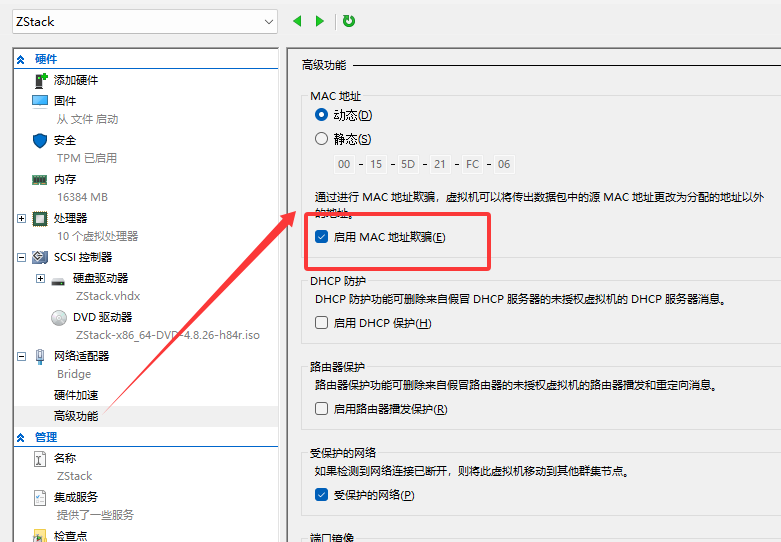

启用网卡混杂模式

启用网卡混杂模式

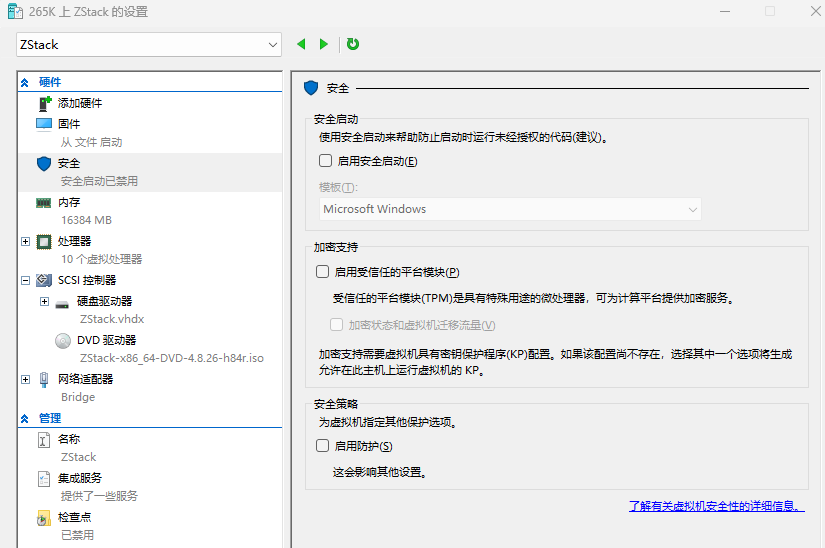

开启嵌套虚拟化

开启嵌套虚拟化

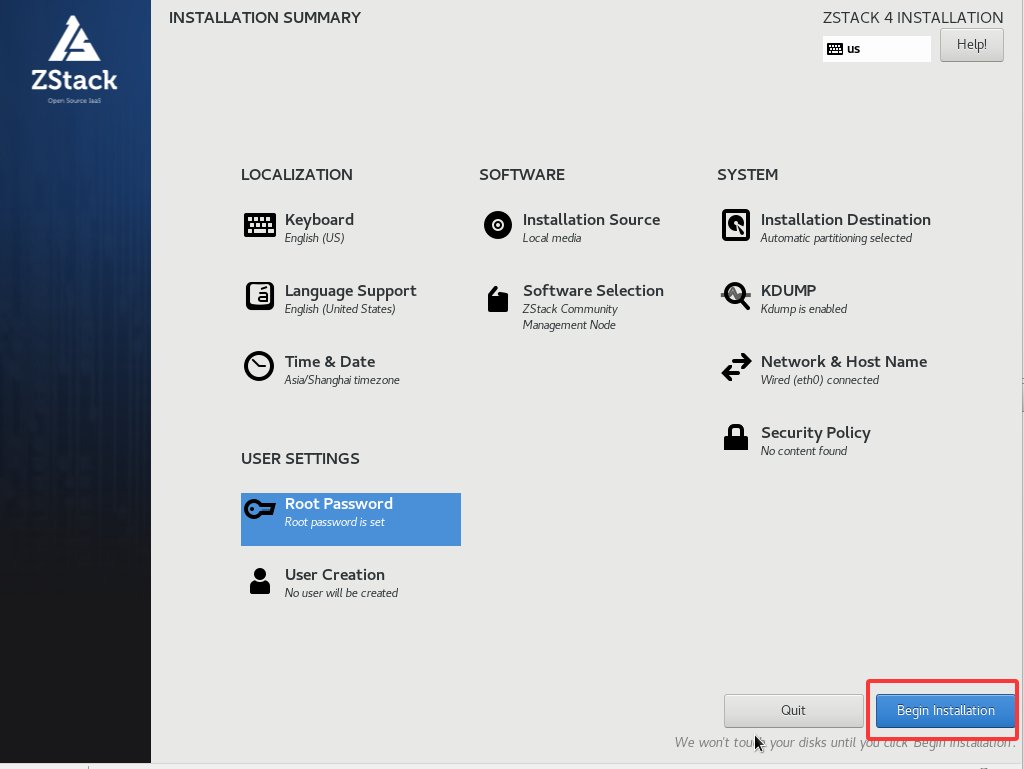

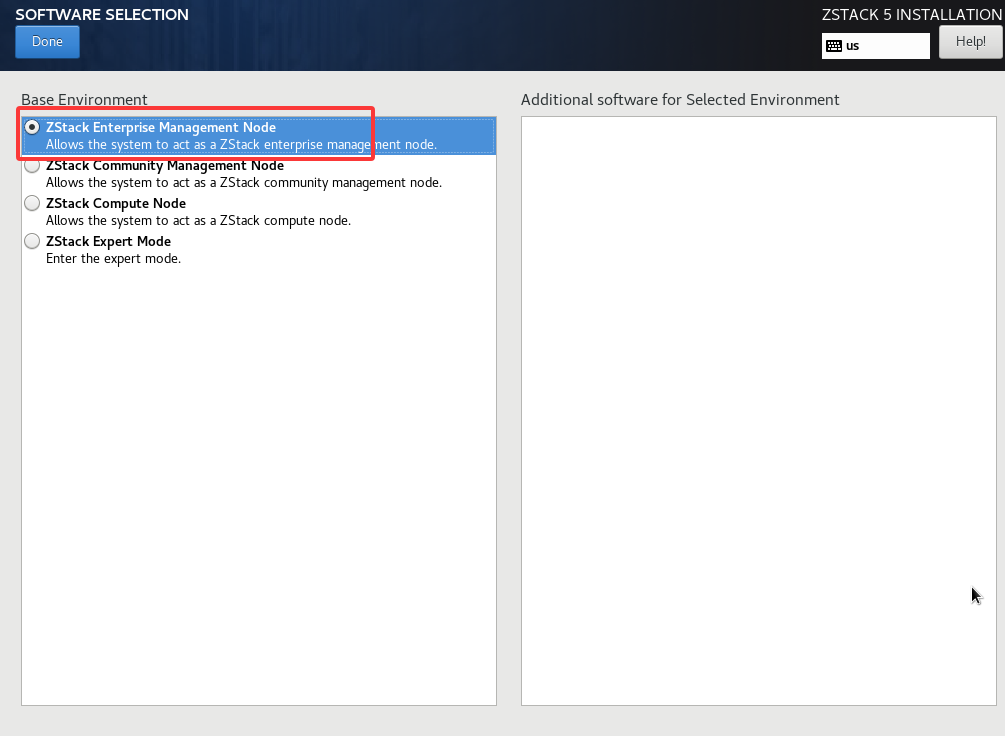

可以选择安装企业版和社会版,企业版没有授权只能管理一个计算节点,社区版则有各种功能限制,但不限制节点数。

如果安装后没有启动Web界面(社区版有可能不自动启动Web界面)需要执行以下命令手动启动

可以选择安装企业版和社会版,企业版没有授权只能管理一个计算节点,社区版则有各种功能限制,但不限制节点数。

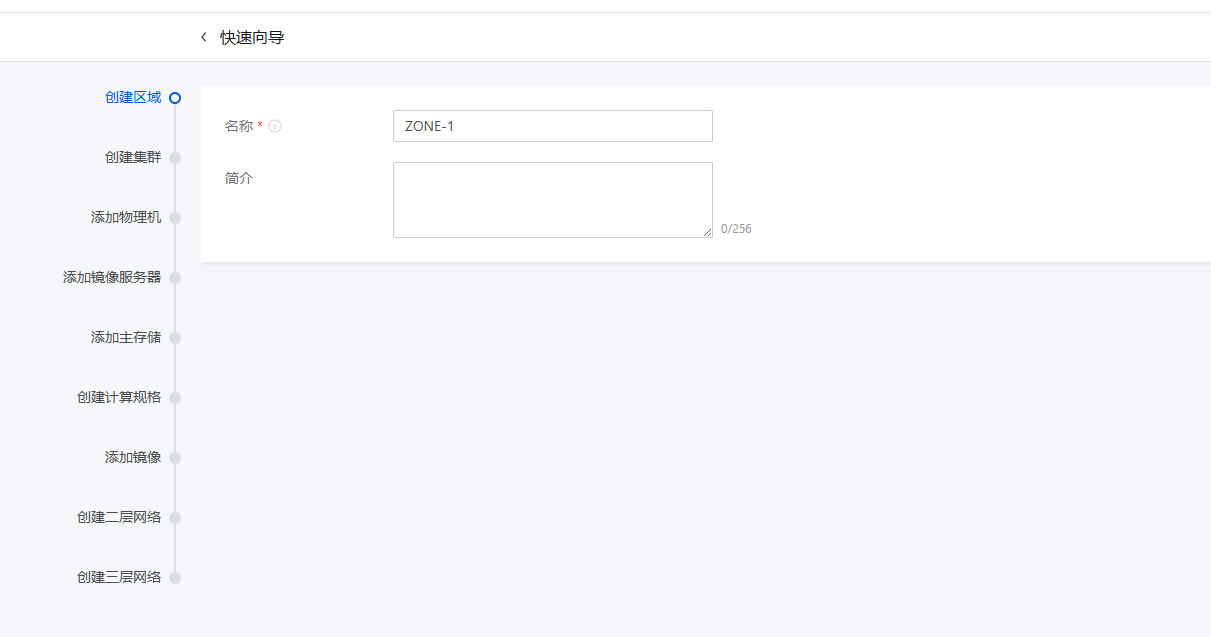

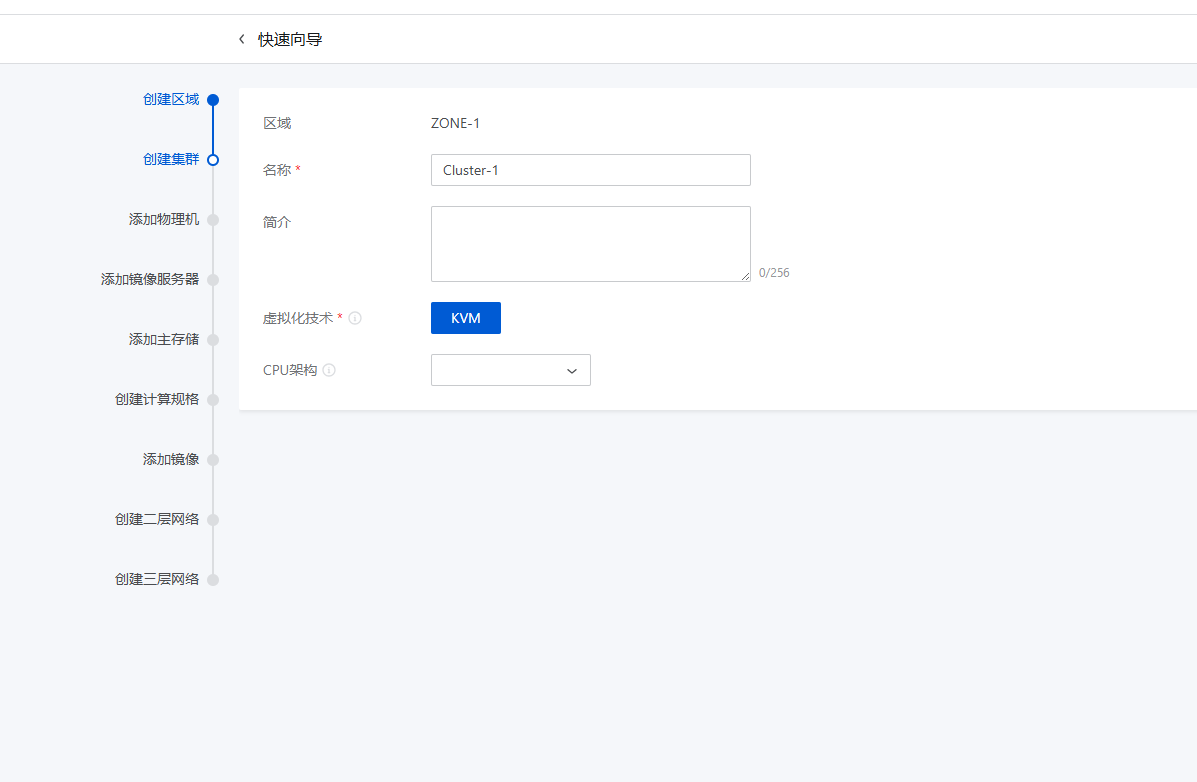

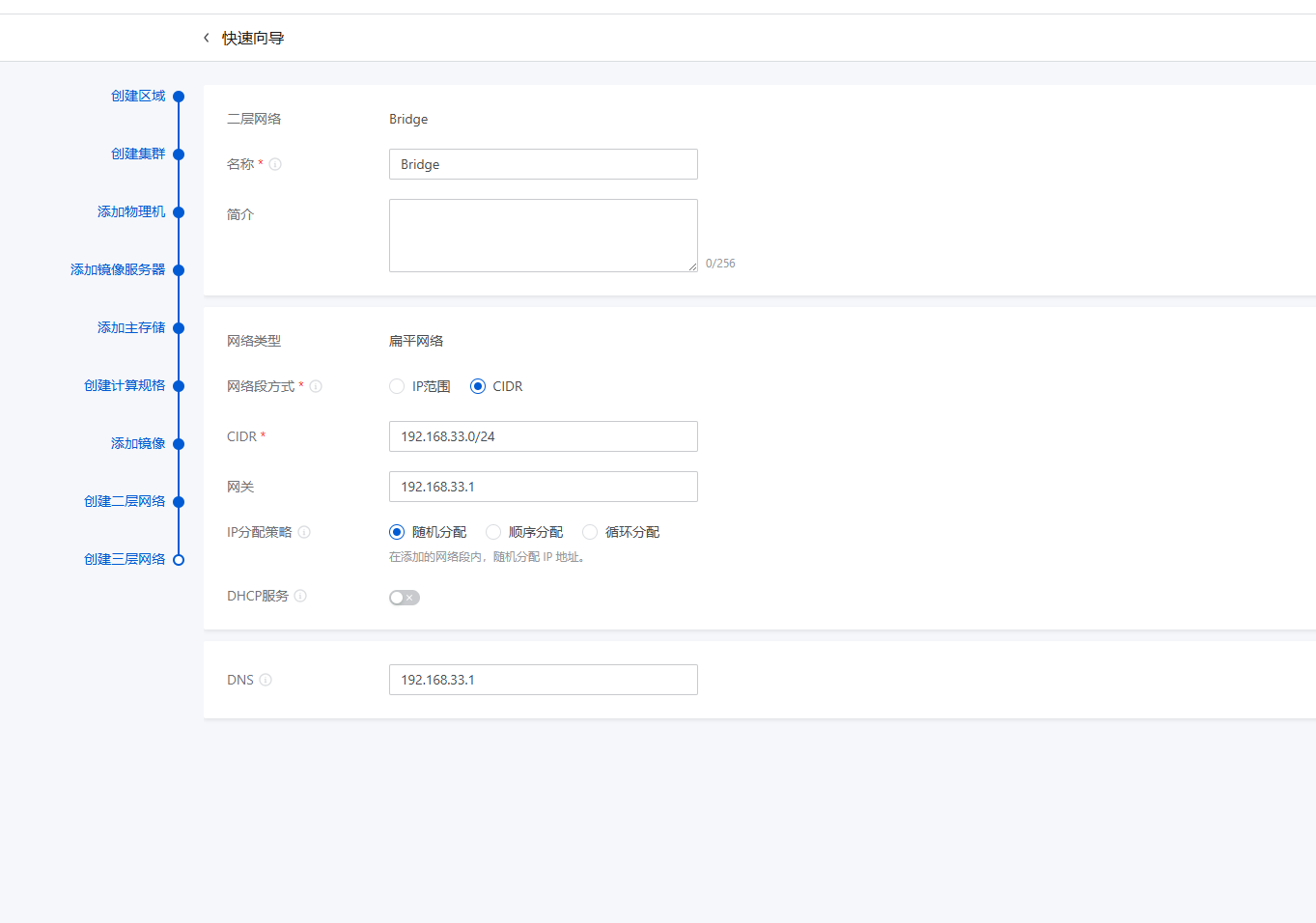

如果安装后没有启动Web界面(社区版有可能不自动启动Web界面)需要执行以下命令手动启动 添加集群,集群是一组计算结点的集合,同一集群中的节点共用存储和网络资源

添加集群,集群是一组计算结点的集合,同一集群中的节点共用存储和网络资源

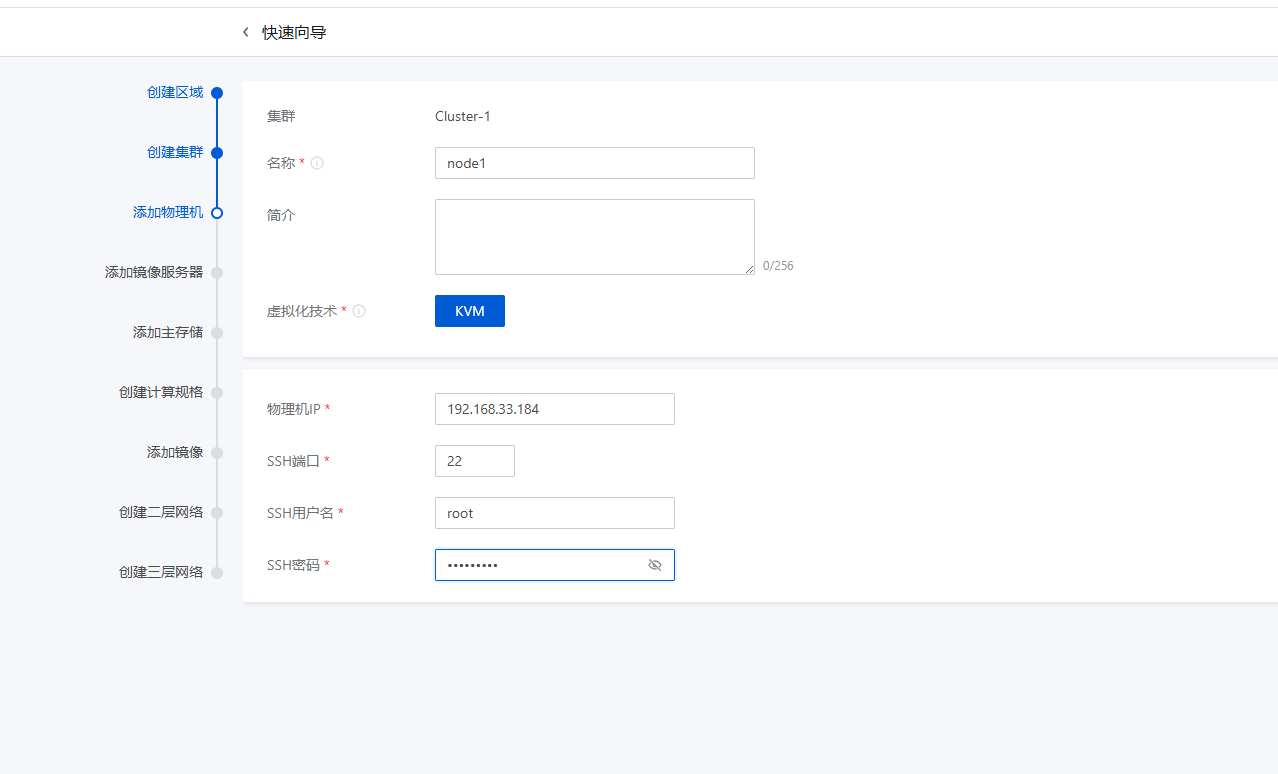

添加物理机,一个物机就一个计算节点,管理节点也可以添加为物理机,ZStack可以管理KVM节点,也可以管理VMware Esix节点

添加物理机,一个物机就一个计算节点,管理节点也可以添加为物理机,ZStack可以管理KVM节点,也可以管理VMware Esix节点

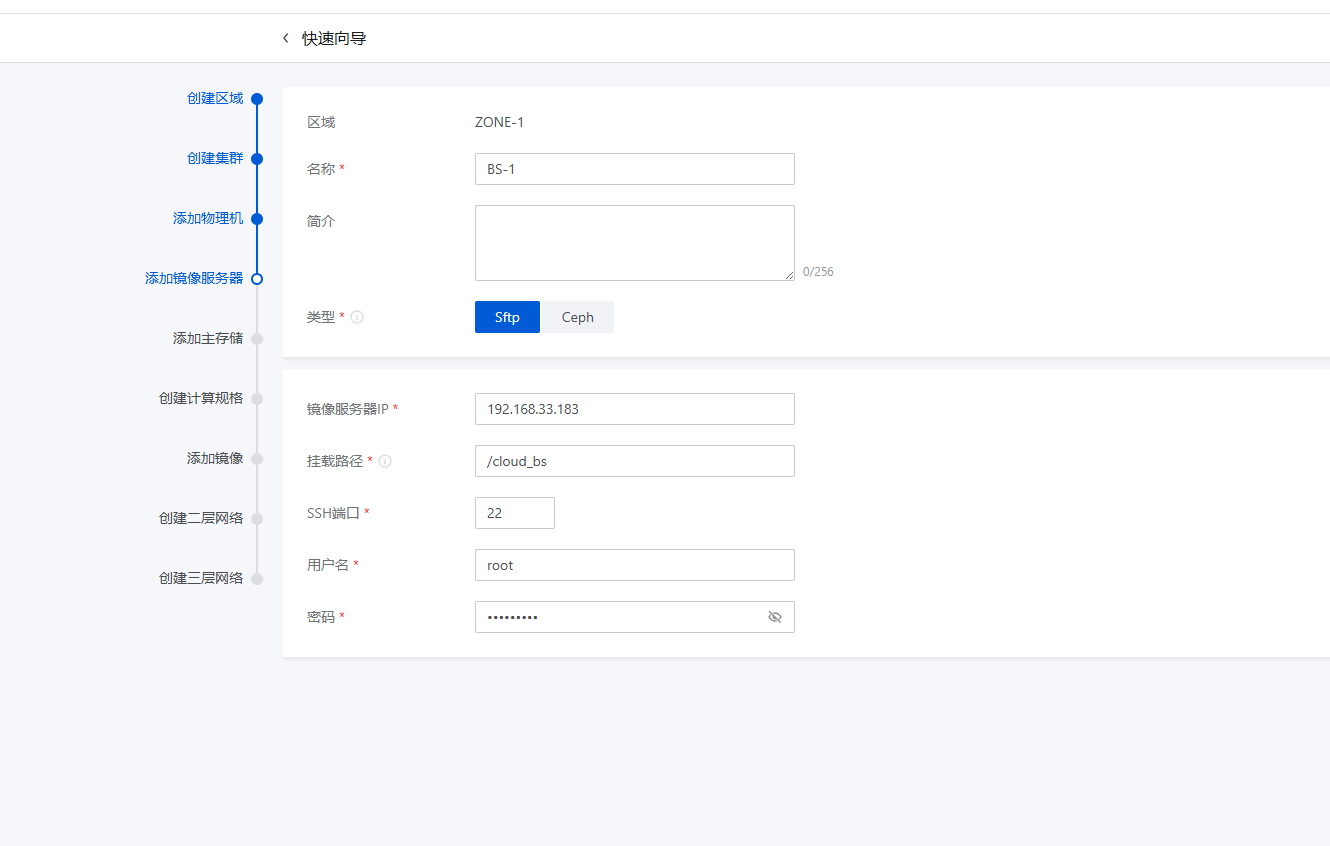

添加镜像服务器,就是一个iso等镜像文件的存储空间,这里是放在管理节点的/cloud_bs目录了

添加镜像服务器,就是一个iso等镜像文件的存储空间,这里是放在管理节点的/cloud_bs目录了

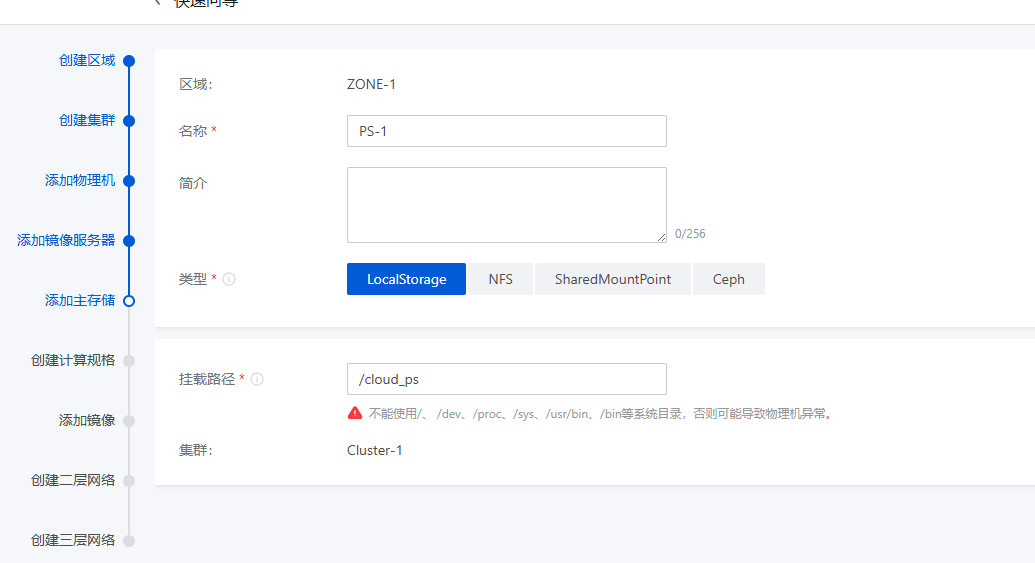

添加存储,这里使用本地存储

添加存储,这里使用本地存储

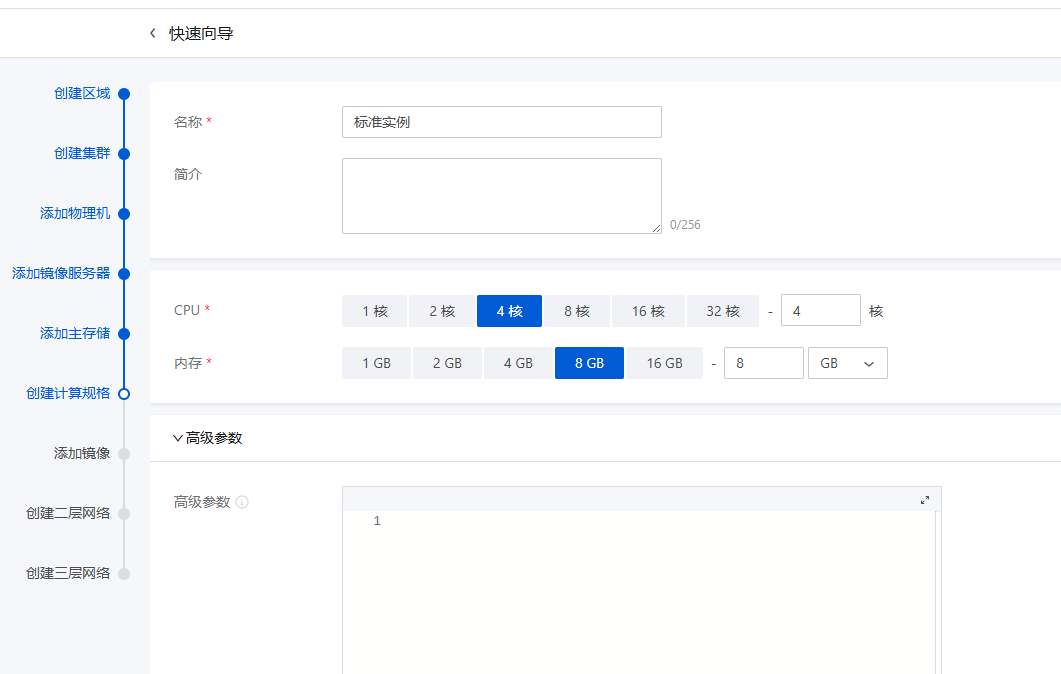

添加实例规格

添加实例规格

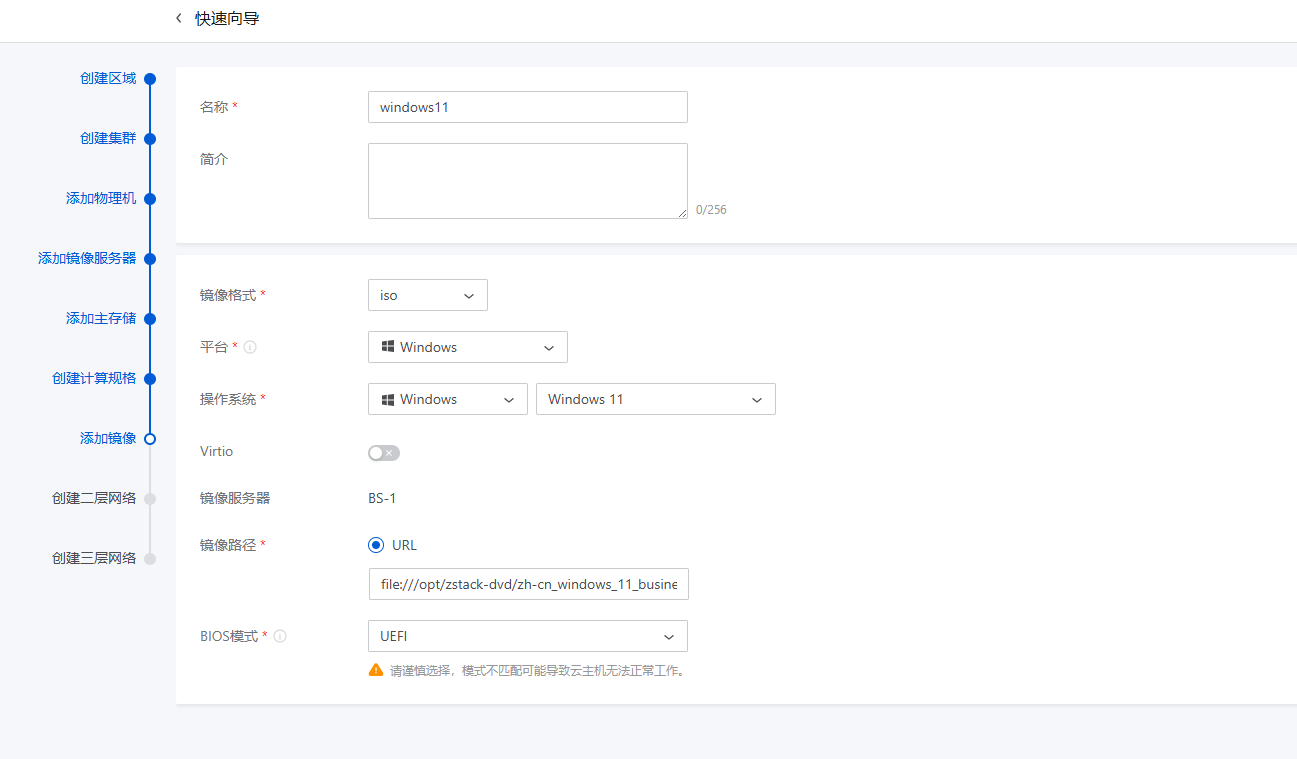

向镜像服务器中添加镜像

向镜像服务器中添加镜像

ZStack会从指定的URL远程下载镜像,也可以通过file://前缀指定本地其它目录的像像

BIOS指的是镜像的启动模式

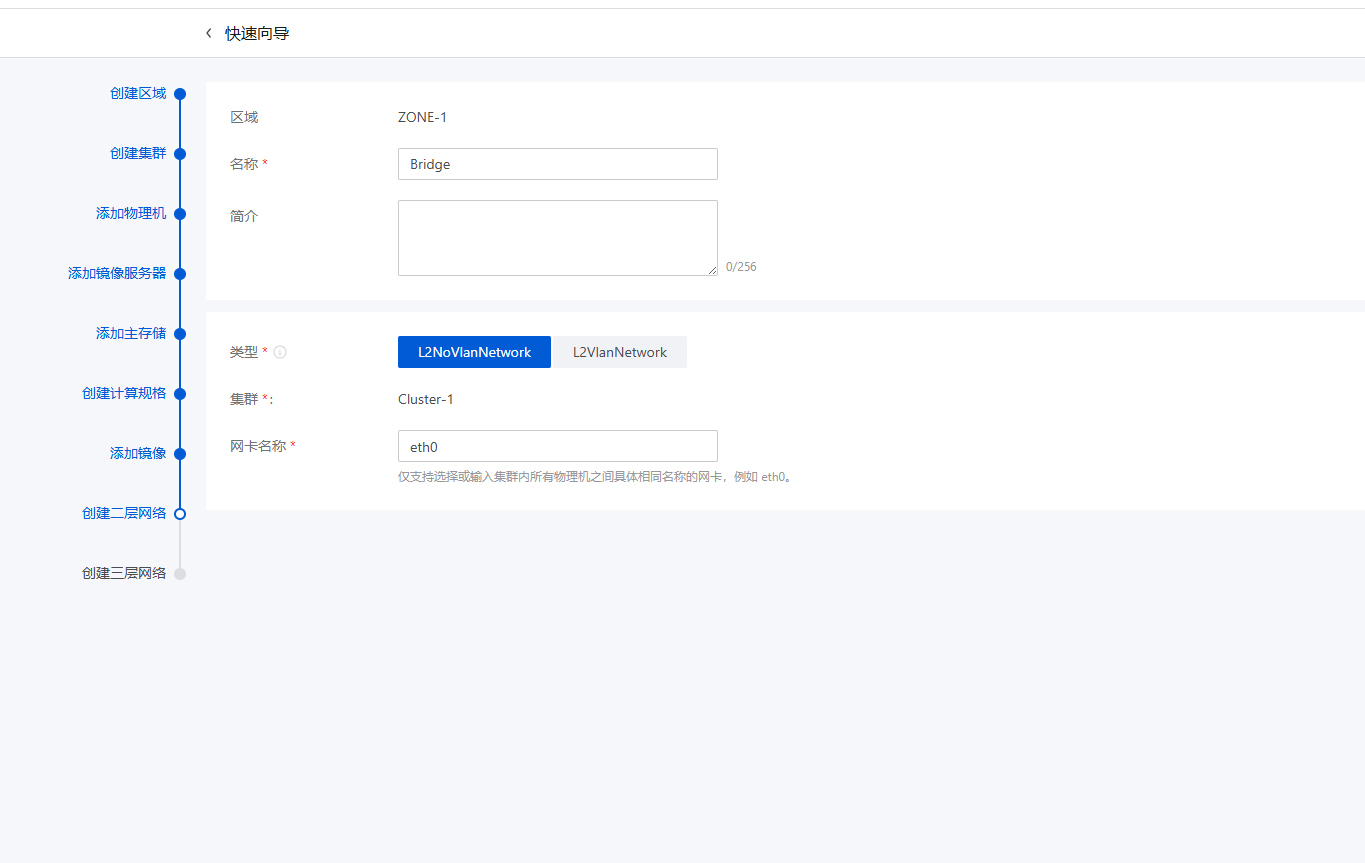

定义网络

ZStack会从指定的URL远程下载镜像,也可以通过file://前缀指定本地其它目录的像像

BIOS指的是镜像的启动模式

定义网络

网卡名称就是物理网卡的设备名

网卡名称就是物理网卡的设备名

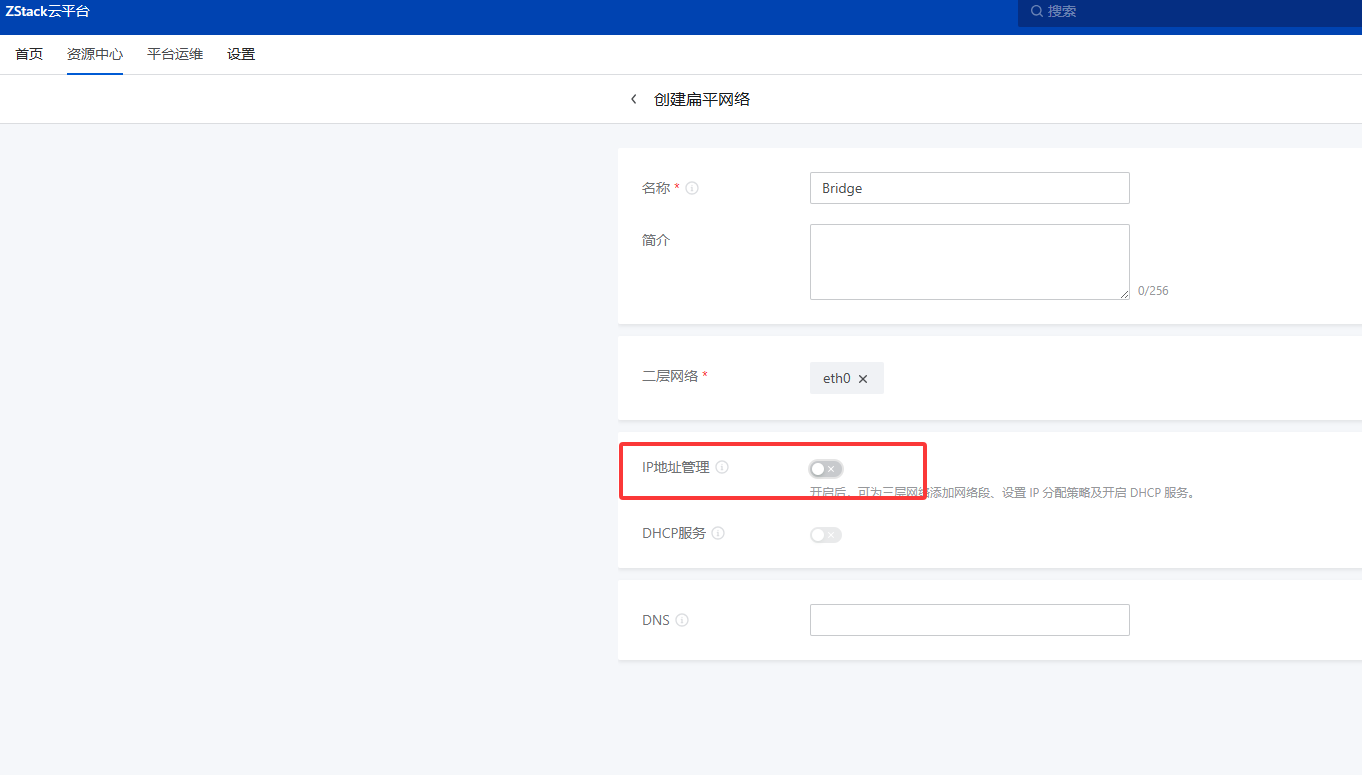

因为我使用的是桥接上网,所以后面要把三层网络删除再重新创建

把上面定义的三层网络删除后再创建一个没有IP地址管理的三层网络

因为我使用的是桥接上网,所以后面要把三层网络删除再重新创建

把上面定义的三层网络删除后再创建一个没有IP地址管理的三层网络

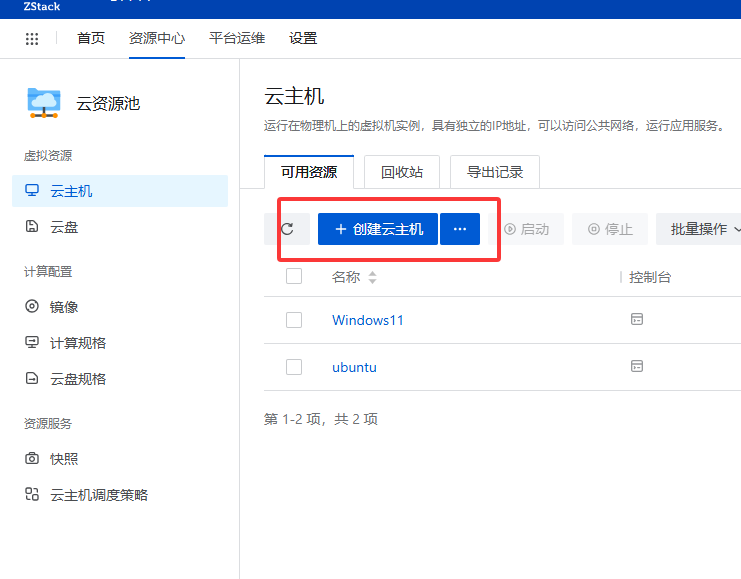

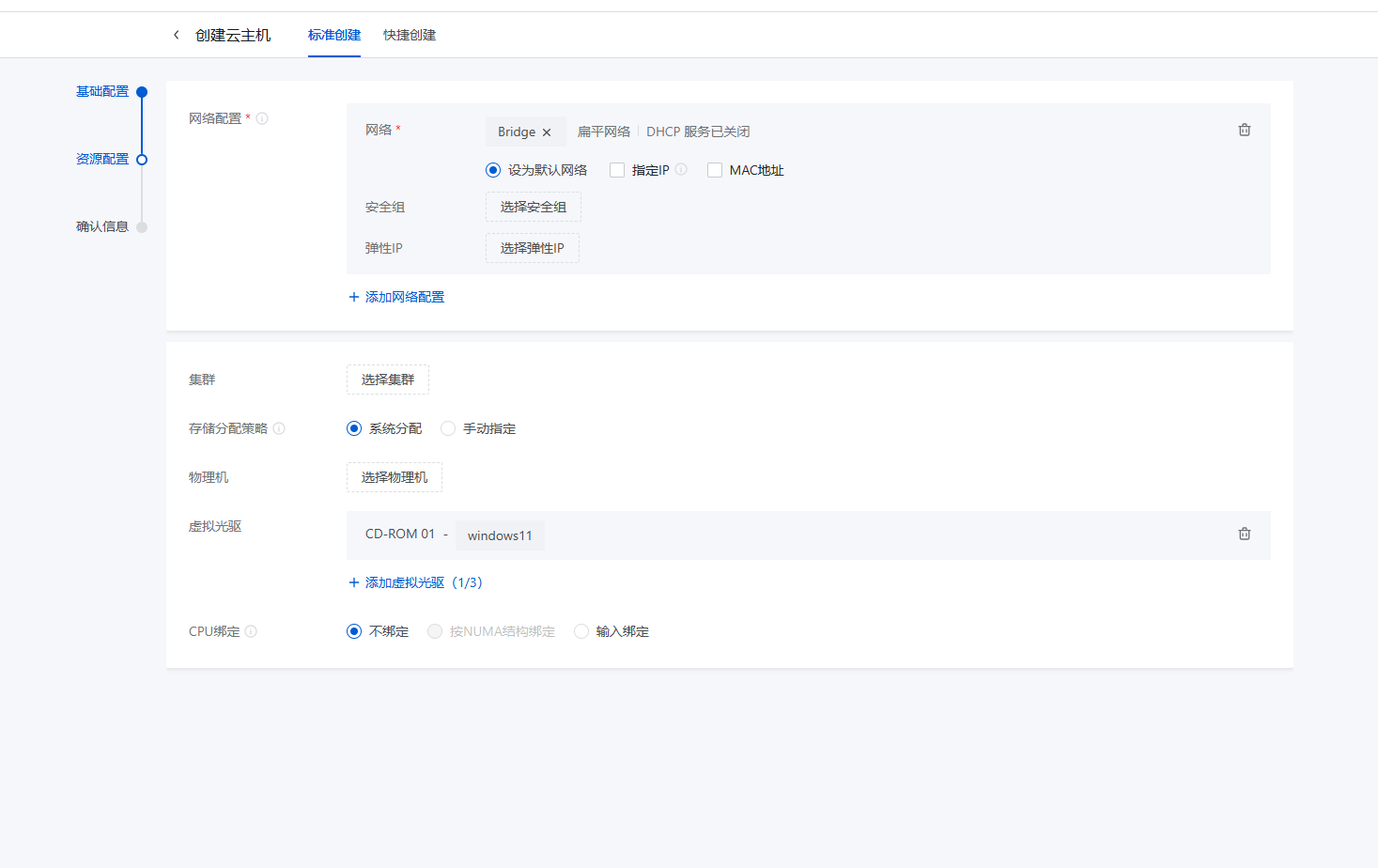

云主机基础规格

云主机基础规格

资源配置

资源配置

信息确认

信息确认

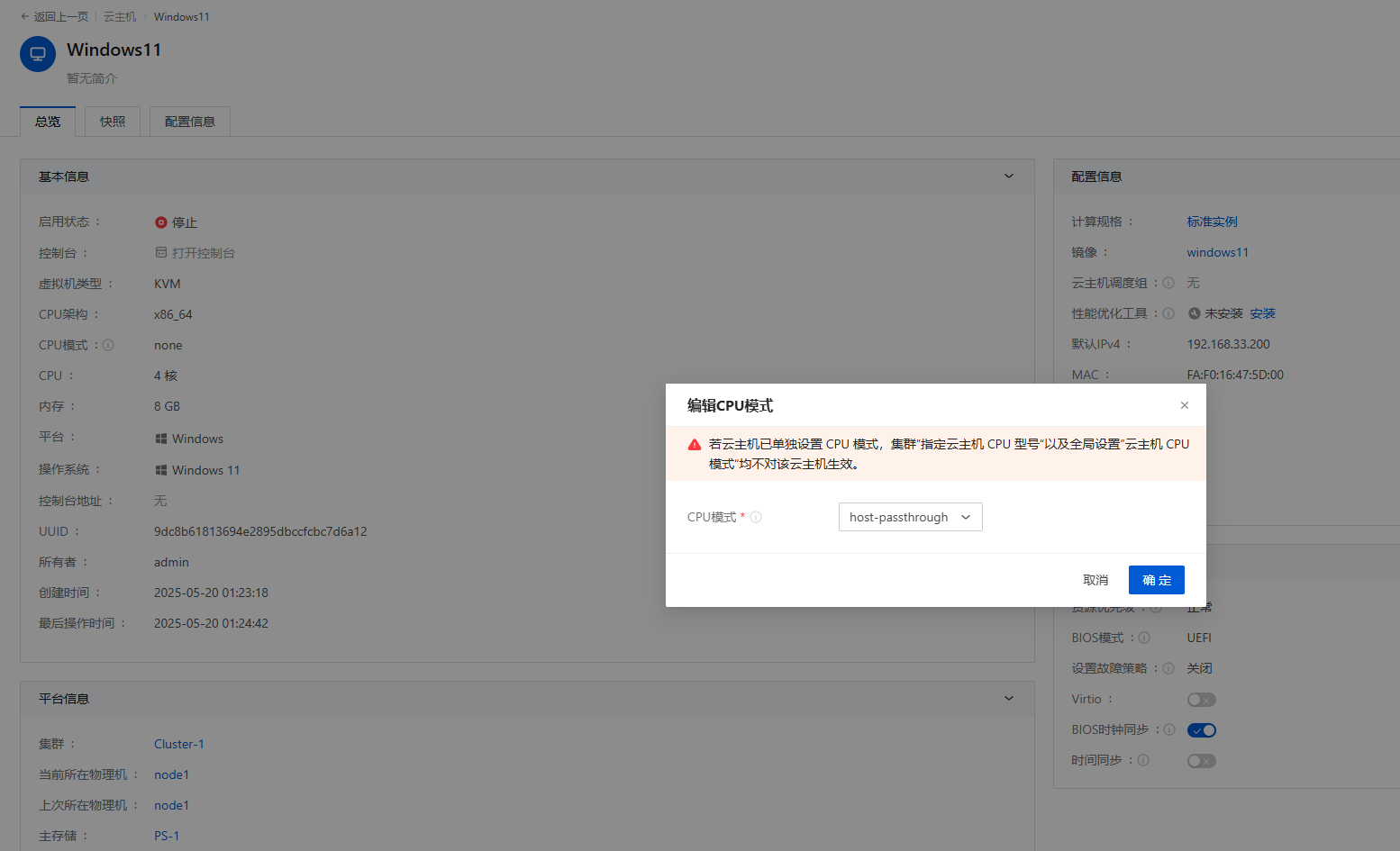

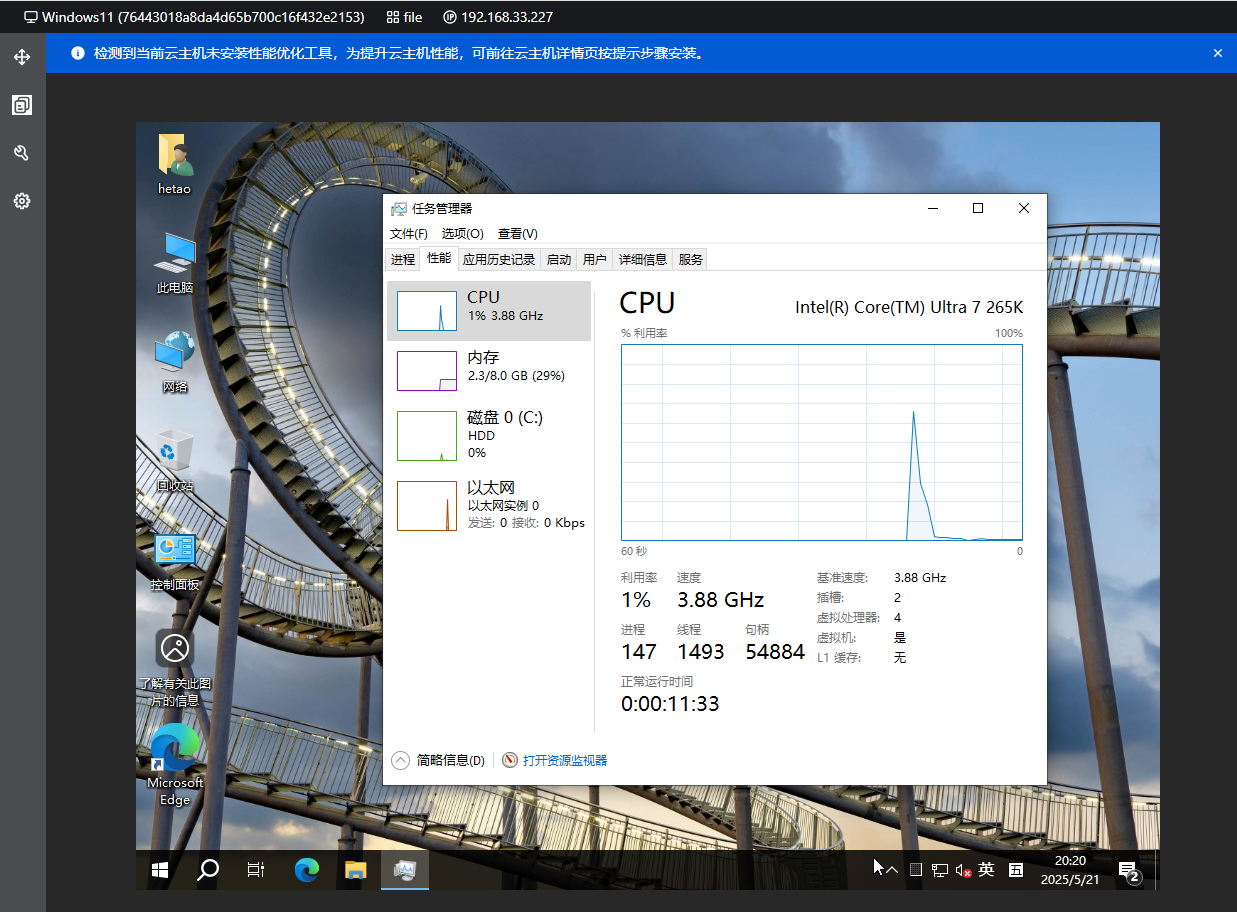

云主机创建完成后还需要修改CPU模式,不然不能发挥CPU的全部功能

云主机创建完成后还需要修改CPU模式,不然不能发挥CPU的全部功能